Tausende Menschen wurden Anfang 2024 von US-Forschern zu einem interessanten Experiment eingeladen. Sie durften eine Verschwörungstheorie nennen, der sie anhängen – und dann darüber chatten. Sie wussten dabei: Ihr Gesprächspartner war kein Mensch, sondern ein Computersystem mit sogenannter künstlicher Intelligenz (KI), auf dem ein assoziatives, lernendes Sprachmodell lief. Es war in der Lage, blitzschnell die passenden Argumente zu finden und zusammenzustellen – und vom Forschungsteam beauftragt, die Probanden in einfacher Sprache von den Fakten zu überzeugen. Ziel der Studie (mit zwei Teil-Untersuchungen)war es, herauszufinden, ob der Software GPT-4 Turbo gelang, was anderen Menschen selten gelingt – nämilch Anhänger von Verschwörungsmythen von ihrem Glauben abzubringen.

Ein wichtiger Unterschied zu früheren Untersuchungen war unter anderem, dass die Probanden nicht mit einer Auswahl vorgegebener Beispiele von Mythen konfrontiert wurden, sondern selbst auswählen konnten. Mit 15 Prozent der Teilnehmer:innen chattete die Maschine über eine Verschwörung rund um das Attentat auf US-Präsident John F. Kennedy 1963. Relativ häufig wurden auch Aliens, die Ursprünge der Corona-Pandemie, die Angriffe auf das World Trade Center in New York am 11. September 2001 und die Apollo-Mondlandungen besprochen. Etwa vier Prozent der Probanden hatten sich den vermeintlichen Betrug zulasten von Donald Trump bei den US-Präsidentschaftswahlen 2020 als Thema ausgesucht.

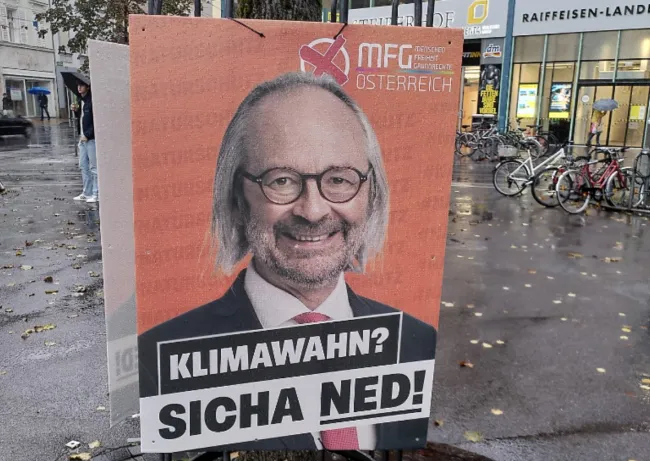

Die österreichische Kleinpartei MFG wurde während der Corona-Pandemie in Gegnerschaft zu Impungen und verbreitete in der Folgezeit auch Verschwörungsmythen, inzwischen macht sie auch angeblich übertriebene Warnungen vor der Klimakrise zum Thema - Plakat zur österreichschen Nationalratswahl 2024; Foto: Carel Mohn

Das Ergebnis des Chats war erstaunlich: Während die Probanden vorher im Mittel auf einer Skala von Null bis 100 („definitiv falsch“ bis „definitiv richtig“) angaben, zu etwa 80 Prozent von der Verschwörungserzählung überzeugt zu sein, sank ihre durchschnittliche Zustimmung danach in den zwei Teilstudien mit leichten Unterschieden erkennbar. Die Probanden wählten nach dem Chat auf der Skala Werte, die um 17 beziehungsweise etwa 12 Punkte stärker gesunken waren als bei den jeweiligen Vergleichsgruppen, die sich mit der KI-Software über ein anderes Thema ausgetauscht hatten. Etwa ein Viertel der Versuchspersonen war danach zu weniger als 50 Prozent überzeugt, zeigten sich also unsicher. In einer der beiden Studien ließ sich der Effekt noch nach zwei Monaten nachweisen (veröffentlicht in Science, hier einige Berichte dazu bei Riffreporter.de, der Süddeutschen Zeitung oder bei Spiegel-Online).

Bisher war Stand der Forschung, dass Fakten ziemlich nutzlos sind beim Argumentieren mit Verschwörungsgläubigen

Dieses Ergebnis ist vor allem deshalb überraschend, weil es anders ausfällt als bisherige Erfahrungen und Erkenntnisse der Wissenschaft. Bisher hatten zahlreiche Studien klar gezeigt, dass Argumente und Fakten relativ nutzlos sind, um Menschen von einem Verschwörungsmythos abzubringen. Deren gängige Reaktion ist dann, die ihnen entgegengehaltenen Belege für gefälscht zu halten, die Gesprächspartner für gekauft oder eingelullt, und so die Verschwörung für noch größer, für noch mächtiger zu erklären.

Die Gründe dafür, dass Menschen solchen Mythen anhängen, sieht die Psychologie weniger in einer rationalen Überzeugung, dass die (vermeintlichen) Belege für die Existenz der Verschwörung stimmen. Stattdessen bieten diese Erzählungen psychologische Vorteile: Sie liefern ein einfacheres Bild als die komplexe Realität. Und sie passen zu Emotionen, Werten und Einstellungen oder der Identität der Betroffenen. Ein klares Beispiel dafür ist der gegen Fakten und Gerichtsurteile resistente Glaube vieler Trump-Anhänger in den USA, ihrem Idol sei der Sieg bei der Präsidentschaftswahl 2020 gestohlen worden. Dies gehörte übrigens bei den aktuellen Experimenten mit dem KI-Chatbot zu den Mythen, von denen ihre Anhänger am wenigsten abrückten.

Auf der Basis ihrer Daten erklärt das Team um Thomas Costello von der American University in Washington DC, es brauche nur die richtigen Argumente und Beweise, damit Menschen den Ausgang aus dem „Kaninchenbau der Verschwörung“ finden. Dieses „überraschend optimistische Bild menschlicher Argumentationskraft“ ziehe die bisherige, „konventionelle“ Forschungslage in Zweifel.

In ersten Reaktionen zeigen sich deutsche Fachleute verblüfft von dem Ergebnis und beeindruckt von der methodischen Umsetzung der Experimente. Gegenüber dem Science Media Center (SMC) sagte etwa Fabian Hutmacher von der Universität Würzburg: „Die Studie scheint mir vor allem deshalb interessant, weil sie belegt, dass man Menschen mit verschwörungstheoretischen Überzeugungen erreichen kann, wenn man auf ihre konkreten Überzeugungen eingeht. Das ist keine Strategie, die man zwangsweise an ein KI-Modell delegieren muss.“

Mit dieser recht positiven Bewertung ist Hutmacher aber eher in der Minderheit der vom Science Media Center befragten sechs Fachleute. Benjamin Krämer von der Universität München beispielsweise bezweifelt, ob „eine einzige, wenn auch augenscheinlich methodisch saubere, Studie sogleich von einer Schlussfolgerung überzeugen sollte, die der bisherigen Literatur und auch der Alltagserfahrung relativ diametral widerspricht. Außergewöhnliche Behauptungen brauchen auch außergewöhnlich gute Belege.“

Die Psychologie und die Kommunikationswissenschaft kennen inzwischen viele Fallstricke der menschlichen Kommunikation. Einer davon ist der Confirmation Bias oder Bestätigungsfehler. Es ist die oft unbewusste Tendenz von Menschen, eher das zu akzeptieren, was der eigenen Haltung entspricht – und sehr kritisch bis ablehnend auf alles zu blicken, was im Widerspruch steht und ein Umdenken verlangen könnte. Diese kognitive Fehlleistung ist nicht auf Menschen mit einem Verschwörungsglauben beschränkt, sondern eher eine allgemeine Eigenschaft der menschlichen Psyche. Sie tritt besonders bei Themen auf, die Menschen wichtig sind, sei es das favorisierte Rezept für Apfelkuchen, die Frage, in welchem Alter Kinder in den Kindergarten gehen sollten oder eben die Überzeugung, in der Politik gehe es nicht mit rechten Dingen zu. Seine Meinung zu bewahren, ist für das Gehirn einfacher und weniger anstrengend, als mögliche Gegenbeweise rational zu prüfen und den eigenen Wissenstand zu verändern – was unter Umständen ja auch ein schlechtes Licht auf das eigene bisherige Verhalten werfen könnte.

Dieser Confirmation Bias trägt dazu bei, dass die Wissenschaft das sogenannte Defizit-Modell der Kommunikation für gescheitert hält. Dieses Modell fußt auf der Annahme, dass Menschen im Wesentlichen faktische Information fehlt, um zum Beispiel in der Klimakrise ins Handeln zu kommen oder Verschwörungsmythen hinter sich zu lassen. Dieses Modell dient vielen Menschen, auch Journalistinnen und Naturwissenschaftlern weiterhin mehr oder weniger bewusst als Grundlage ihres Kommunizierens: Sie liefern also immer weitere Informationen in der Annahme, dies werde das Gegenüber doch irgendwann überzeugen. Dabei gibt es klare Belege und viele Aussagen dazu, dass zumindest in emotional bedeutsamen Fragen fehlendes Wissen eben nicht der ausschlaggebende Faktor dafür ist, etwas zu tun oder nicht zu tun. Zu diesen Fragen können auch das Rauchen, die Einstellung zum Klimaschutz oder eben der Glauben an einen Verschwörungsmythos gehören.

Die neue Studie des Teams um Thomas Costello bestärkt hingegen das Defizit-Modell. Doch auch Wissenschaftler:innen – und dieser Autor – können dem Confirmation Bias unterliegen. Zwei der drei Autoren der Science-Veröffentlichung haben in der Vergangenheit viel über Fake News in Sozialen Medien veröffentlicht und unter anderem die These vertreten, Menschen wollten Fehler und Falschinformation eigentlich vermeiden. Sie würden aber nicht oft genug daran erinnert, über die Korrektheit eines Posts nachzudenken, bevor sie ihn weiterleiten. Demnach seien Menschen also eigentlich grundsätzlich an den Fakten interessiert und dafür empfänglich. Auch einer der Autoren eines lobenden Kommentars in Science hat in der Vergangenheit mit den beiden zusammen Studien mit ähnlichen Aussagen veröffentlicht.

Der Verfasser dieses Artikels wiederum hat das Handbuch Klimakommunikation unter anderem auf der Erkenntnis aufgebaut, dass das Defizit-Modell für die Klimakommunikation widerlegt und nicht hilfreich ist. Stattdessen sind Fakten zwar eine notwendige, aber keine hinreichende Voraussetzung für Erfolg in der Kommunikation.

Wissenschaft ist nun aber der organisierte Versuch, menschliche Neigungen zu kognitiven Fehlleistungen und voreiligen Schlussfolgerungen zu neutralisieren. Dazu dient zum einen die grundsätzliche Skepsis gegenüber plötzlichen, weitreichenden Veränderungen der Studienlage, zum anderen das System der internen Kontrolle durch Peer Review und Reproduktion von Ergebnissen. Eine einzelne Studie kann fast nie den Stand der Wissenschaft revidieren. Auch im Journalismus ist es eine Frage der Professionalität, sich der eigenen Impulse bewusst zu werden und ihnen zunächst zu misstrauen. Da bei der vorliegenden Studie der Confirmation Bias und das Defizit-Modell zentrale Elemente des Forschungsgegenstandes sind, muss die Prüfung und Selbstprüfung besonders sorgfältig erfolgen.

Daher zu den Details der beiden Teilstudien: Die Probanden wurden über das Internet und den Dienst CloudResearch Connect rekrutiert und nach einigen Kriterien demografisch ausbalanciert. Viele von ihnen gelten aber als „professionelle“ Versuchspersonen, die mit ihrer Teilnahme an Experimenten auch Einkommen erzielen; das schränke die Repräsentativität ein, wie die Forscher um Costello selbst anmerken (in anderen Untersuchungen, zum Beispiel hier, wird die Qualität der Antworten auf diesem Dienst eher gelobt).

Auf diese Einschränkung hat das Forschungsteam auf zweierlei Weise reagiert. Es hat zum einen bei der zweiten Teilstudie verhindert, dass die Probanden ihre Beiträge zum Chat in das entsprechende Fenster hineinkopieren konnten. Das schloss die theoretische Möglichkeit aus, dass die Teilnehmer:innen sich aus anderen KI-Modellen bedienten und überhaupt nicht selbst bei der Sache waren, sondern möglichst einfach ihr Honorar verdienen wollten. Diese Veränderung (und eine weitere) ging mit dem Rückgang des Effekts, also der Reduktion des Verschwörungsglaubens, von 17 auf 12 Punkte einher.

Zum anderen warb das Forscherteam noch über einen anderen Dienst, wo Probanden als weniger professionell galten, eine kleinere Zahl von Probanden an: Hier war der Rückgang des „Glaubens“ an den Verschwörungsmythos zwar weniger stark, aber ebenfalls deutlich.

So beeindruckend die Zahlen auch nach diesen Anpassungen zwischen den Teilstudien waren: Alle Probanden hatten einen Grund, mit dem KI-Modell zu chatten, der sich aus der Studiensituation und aus ihrer Anmeldung als Versuchsperson bei einem der Internetdienste ergab. Das schränkt die Übertragbarkeit auf andere Situationen womöglich ein. „Es bleibt aber unklar, ob Menschen mit stark ausgeprägtem Verschwörungsglauben ohne direkte Anweisung innerhalb einer Studie eigenmotiviert eine solche Diskussion mit Chatbots führen würden“, sagt Philipp Schmid von der Radboud University.

In den Experimenten könnte überdies schon das Bewusstsein, an einem Versuch teilzunehmen, das Ergebnis verzerrt und den gemessenen Effekt vergrößert haben. „Die direkte Meinungsänderung ist wahrscheinlich eher eine direkte Folge des experimentellen Designs, denn die Personen sollen unmittelbar vor und nach dem Gespräch mit dem Chatbot angeben, wie stark sie ihre selbst vorgebrachte Verschwörungstheorie als ‚wahr‘ empfinden“, bemerkt Nicole Krämer von der Universität Duisburg-Essen. In dieser Situation könnten manche Probanden den sanften Druck empfunden haben, dass sie ihre Meinung geändert haben sollten, wenn schon ein solcher Aufwand getrieben wird. „Solche Änderungen sind eher Artefakte, die durch die experimentalpsychologische Situation zustande kommen und keine wirkliche Meinungsänderung bedeuten müssen“, ergänzt Krämer. Beeindruckend sei jedoch der Nachweis, dass der Effekt auch nach zwei Monaten noch nachweisbar war.

Verschwörungsanhänger trafen auf ein Gegenüber, das mehr wusste über die Verschwörung als sie selbst

Interessant war auch der typische Verlauf der Chats. Zunächst fasste das KI-Modell die von den Probanden genannte und begründete Verschwörungstheorie zusammen und bat dann darum, die Stärke des eigenen Glaubens an die Theorie auf einer Skala von 0 (sie stimmt überhaupt nicht) bis 100 (sie stimmt eindeutig) einzuordnen. Der erste Schritt dabei, die neutrale Wiedergabe der Äußerungen, ist eine in der Kommunikationswissenschaft bekannte vertrauensbildende Maßnahme, die auch für Unterhaltungen zwischen Menschen empfohlen wird: Sie zeigt, dass das Gegenüber zuhört und nicht sofort urteilt (zum Beispiel beim aktiven Zuhören).

Dann folgten drei ziemliche lange Textantworten des Chatbots auf recht kurze Einwände oder Gegenfragen der Probanden. Die Antworten waren voller Details, Fakten und Argumente. Unklar bleibt, ob die Versuchspersonen sich erschlagen fühlten – und ob sie in einem realen Gespräch so lang am Stück zugehört hätten, ohne zu unterbrechen, einzuhaken, im Detail zu widersprechen. Das kann einerseits mit der technischen Situation zu tun haben, weil die langen Antworten auf einen Schlag auf dem Bildschirm standen. Andererseits kann es mit der spezifischen Antwort zu dem selbstgewählten Thema zusammenhängen: „Verschwörungsgläubige treffen quasi erstmal auf einen Gesprächspartner, der noch mehr über ihre Lieblingsverschwörungstheorie und die Hintergründe weiß als sie selbst. Das ist nicht unplausibel“, interpretiert das Roland Imhof von der Universität Mainz.

Dabei bleibe aber offen, warum die Versuchspersonen dem Chatbot vertrauen, so der Experte weiter. Denn die Teilnehmer:innen haben offenbar nicht angenommen, was bei menschlichen Gesprächspartnern oft passiert, dass das Gegenüber selbst Teil der Verschwörung ist. „Das scheint der KI nicht unterstellt zu werden, und das ist für mich das Verblüffende“, wundert sich Imhof. „Zusatzanalysen der Studie zeigen auch, dass die Reduktion umso größer ist, je mehr die ProbandInnen der KI vertrauen.“

Dass die Probanden den KI-Chatbot offenbar als neutral akzeptierten, könnte sich schnell ändern

Dass es Gründe gibt, dem Output der assoziativen Sprachmodelle nicht blind zu vertrauen, ist bereits vielfach nachgewiesen. Sie verfügen nicht wirklich über Intelligenz oder Wissen, sie ziehen auch keine logischen Schlüsse, sondern stützen sich auf eine massive Datenbasis von Schriftstücken, aus denen sie statistisch ableiten, was in welchem Zusammenhang geschrieben und wie es bewertet wird. Was genau dabei passiert, wissen auch die Macher der Modelle oft nicht. Fließen auch Fake News in diese Sammlung ein, kann KI diese reproduzieren und als wahr ausgeben. Zudem wiederholt und verstärkt ein solches System gängige Stereotypen, hat also keinen Begriff von Wahrheit, sondern nur von Häufigkeit. Die Qualität der Aussagen hängt daher sehr davon ab, womit die KI gefüttert wurde.

Diese generelle Einschränkung stellt die Zuverlässigkeit der Science-Studie nicht unbedingt in Frage. Die Autoren haben eine Stichprobe von 128 der Aussagen, die Chatbots in den Experimenten äußerten, später menschlichen Faktenprüfern vorgelegt: Demnach waren mehr als 99 Prozent korrekt, der Rest irreführend, aber keine einzige falsch. Diese Quote, sagt Nicole Krämer, sei angesichts der „oft diskutierten Halluzinationen von generativen KI-Systemen erstaunlich“.

Solche Checks und Überlegungen betreffen aber nur die Frage, ob die Probanden der Experimente den Chatbots objektiv gesehen vertrauen konnten. Sie erklären nicht, warum sie ihnen offenbar subjektiv vertraut haben. Hier kommen die psychologischen Faktoren wie Emotionen und Identitäten, die das Team um Costello eigentlich durch die Kraft der Rationalität und der Argumente ersetzen wollte, aber doch wieder ins Spiel. Oder können ins Spiel kommen, wenn das Verfahren das Labor verlässt. Noch ist KI eine Neuheit, und Menschen in den USA neigen eher dazu als etwa Deutsche, Innovationen und Technologie erst einmal gut zu finden und optimistisch aufzunehmen. Dafür ist dort viel weiter verbreitet, dass Menschen einzelnen Quellen und Medien grundsätzlich nicht vertrauen, wie sich etwa am polarisierten Publikum der Nachrichtensender CNN und Fox News zeigen lässt.

Dass Chatbots allgemein als neutrale Quelle verstanden werden, auf die man sich einlassen kann, ohne die eigene Identität in Frage zu stellen, muss nicht so bleiben – vor allem, wenn sie breiter genutzt werden sollen, um in der politischen Auseinandersetzung und in den Soziale Medien den Fakten zu mehr Geltung zu verhelfen. Die Anwendbarkeit in der realen Welt bezweifeln daher einige der Fachleute in der SMC-Umfrage. Die Idee, dass in Sozialen Medien routinemäßig im Hintergrund eine KI-Software alle Posts mitliest und bei Falschinformationen eingreift, halten sie für unrealistisch. Eine solche Funktion würde schnell als Zensur verschrien und müsste in der Tat sehr hohe Anforderungen an die Qualität ihrer Interventionen erfüllen.